Il rapporto tra gli Usa e la tecnologia sembra, in questi giorni, farsi sempre più complesso e rivelare, improvvisamente, tutti gli interrogativi riguardo alla compatibilità fra democrazia e tecnocrazia.

Se infatti le recenti rivelazioni del The Guardian dipingono un Paese che controlla, tramite l’Nsa, le telefonate dei propri cittadini, è forse ancora più allarmante il monito lanciato, in questi giorni, dall’Onu. La Commissione sui Diritti Umani delle Nazioni Unite sta infatti per pubblicare un rapporto al fine di proibire la possibilità che le macchine possano prendere “decisioni sulla vita e la morte nei conflitti armati“. Una vera moratoria contro robot e droni volanti impiegati, spesso indiscriminatamente, nei teatri di guerra: macchine ormai capaci di uccidere anche senza un input diretto di un essere umano. Uno scenario fantascientifico ma la realtà, come spesso accade, supera l’immaginazione.

La guerra dei robot

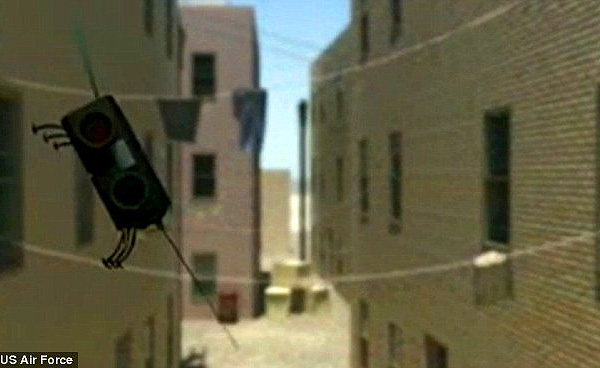

Droni e macchine automatiche sono già fra noi, e non da oggi. Se negli ultimi tempi qualche drone, adibito ad uso civile, ha fatto capolino nei cieli delle nostre città, in Medio Oriente l’uso di queste macchine per scopi bellici vanta una storia decennale. Un drone è un aereo di piccole o medie dimensioni, capace di volare e di compiere operazioni complesse senza la necessità di essere guidato da un pilota umano. Dallo spionaggio al controllo video fino ad arrivare agli omicidi mirati in teatri di guerra, questi robot hanno avuto, in questi anni, molteplici modalità di utilizzo. La storia dei droni inizia nel 2004 durante la presidenza Bush. La Casa Bianca inizia ad utilizzarli per omicidi mirati nei confronti dei capi di al Qaeda in Pakistan, Yemen e Somalia. Fino ad oggi la CIA ha condotto 355 operazioni con i droni dall’inizio del programma. Circa 300 di queste sono state effettuate sotto la Presidenza Obama. Una vicenda controversa e spinosa per un Presidente insignito del premio Nobel per la pace, impegnato a far rientrare la “guerra al terrore”, iniziata da George Bush, nel perimetro della legalità. Certo, queste macchine si prestano all’utilizzo in contesti di guerra non convenzionali, dove non ci sono veri eserciti, ma terroristi nascosti nei luoghi più impensabili. Hanno poi il vantaggio di essere molto più economiche degli aerei convenzionali, sia in termini monetari sia in termini di vite umane di soldati americani. Tuttavia nel corso del tempo i droni sono stati usati in maniera sempre più indiscriminata contro qualsiasi sospettato, con distinzioni sempre più approssimative fra civili e terroristi (secondo una stima approssimativa fatta del Bureau of Investigative Journalism, le persone uccise tra il 2002 e il gennaio del 2013 sarebbero 3.061,di cui 2.629 in Pakistan. Tra queste ci sarebbero anche 558 civili).

Al confine della legalità

Nel suo recente discorso sulla Sicurezza, il presidente degli Stati Uniti ha annunciato di aver firmato una nuova serie di linee guida per il controllo degli attacchi con droni. Gli attacchi dovrebbero dunque essere inseriti in una cornice di maggiore legalità, sottraendoli alla gestione segreta della Cia (divenuta in questi anni quasi un’organizzazione paramilitare) e affidandoli al Pentagono. Scelte obbligate dopo l’ammissione da parte dell’amministrazione Usa dell’uccisione, per mezzo dei droni, di ben quattro cittadini americani. Nel 2011 gli aerei senza pilota hanno eliminato in Yemen l’imam radicale americano-yemenita Anwar al-Awlaki, ritenuto vicino ad al Qaeda . Nella stessa operazione è rimasto ucciso Samir Khan e, successivamente, in Pakistan, il figlio dell’imam Jude Moahmed. Tutti cittadini americani uccisi fuori dai confini nazionali senza nessun processo. Fino a ora queste operazioni sono state giustificate facendo riferimento all’ Authorization for the use of military force against terrorists (l’Autorizzazione all’uso della forza militare) voluta dal Congresso all’indomani dell’11 settembre. Questa legge, in nome della legittima difesa, conferisce al presidente il potere di “usare tutti i mezzi necessari” contro i terroristi che minacciano la sicurezza degli Stati Uniti. Tuttavia il principio di distinzione, sancito dalla Convenzione di Ginevra, secondo il quale bisogna sempre differenziare tra obiettivi civili e militari, perde ogni valore. Ma se la legislazione internazionale, aggiornata al massimo alla seconda guerra mondiale, si riferisce ad armi ed eserciti convenzionali, è chiaro che l’utilizzo di armi robotiche e automatiche richieda un nuovo tipo di legislazione. Come richiesto dall’Onu è dunque necessaria una pausa di riflessione per stabilire delle nuove regole. Anche perché, come ha sottolineato il relatore dell’Onu, Christof Heynes, che ha proposto la moratoria sullo sviluppo dei Lars (lethal autonomous robotics), ci sono armi autonome che vanno anche al di là dei tanto controversi droni, comandati a distanza. “Mentre per i droni spetta ancora ad un essere umano decidere se ricorrere all’uso letale della forza”- denuncia il delegato Onu – “la tecnologia dei nuovi killer robotici include computer a bordo che scelgono autonomamente gli obiettivi da eliminare”.

La morale delle macchine

Secondo il logico inglese Bertrand Russell :“uno dei mali principali del nostro tempo consiste nel fatto che l’evoluzione del pensiero non riesce a stare al passo con la tecnica, con la conseguenza che le capacità aumentano, ma la saggezza svanisce”. La riflessione giuridica, ma soprattutto etica attorno alle nuove armi introdotte in queste anni sta partendo solo i questi ultimi mesi, mentre gli sviluppi della tecnica sono ad uno stadio ben più avanzato. Armi robotiche, i droni e quant’altro garantiscono oggi un’enorme facilità di uccidere. Una facilità non solo meccanica ma anche e soprattutto morale. Si pensi all’ ”effetto play station” che si ottiene bombardando un covo di nemici davanti ad un pc a chilometri di distanza piuttosto che sul campo di battaglia. La differenza è notevole. E in effetti la scelta etica e il suo peso non possono essere stabilite una volta per tutte e cambiano notevolmente in relazione alle varie situazioni. Una questione di scelta che solo un essere umano può compiere, assumendo su di sé il peso, spesso tragico, che ne consegue.

La tecnologia per deresponsabilizzare completamente l’uomo esiste già e ormai si parla di caricare le varie convenzioni nella memoria delle macchine da guerra prossime venture, in modo che possano agire senza violare la legalità internazionale. Purtroppo non è possibile stabilire una volta per tutte i criteri etici da seguire nei vari contesti. È necessario, invece, un continuo confronto fra i princìpi e la realtà. Una realtà di volta in volta mutevole e cangiante con la quale negoziamo le nostre scelte etiche.

Il dilemma del conducente del treno

Non è da condannare la tecnologia in sé: spesso l’arte della guerra ha sviluppato invenzioni e innovazioni che, sebbene nate per scopi bellici, hanno poi contribuito a migliorare la vita umana in ambito civile. È dunque probabile che presto droni e robot potranno essere usati per soccorrere le vittime di disastri naturali o di vari tipi di incidente. Ciò che è pericoloso è il tentativo di delegare alla tecnica anche scelte su valori non negoziabili come appunto quello della vita umana. Per dimostrare quanto sia complesso prendere decisioni in campo etico e morale basti citare il famoso paradosso del conducente il cui treno, lanciato a tutta velocità e privo dei freni, sta per investire 5 operai intenti a lavorare sui binari. Chiunque nei panni di quel conducente, pur di salvare i dieci operai, accetterebbe di deviare il corso del treno, anche se la deviazione comportasse la probabile uccisione di una singola persona che si trova su un binario parallelo. Ma se per fermare il treno fosse necessario, invece che deviarne il percorso mediante una leva, spingere manualmente una persona, magari corpulenta, giù da un ponte per frapporla fra il treno e i dieci operai, nessuno sarebbe d’accordo. Eppure la situazione è formalmente identica: sacrificare una vita per salvarne cinque. Per un robot non farebbe nessuna differenza, ma per la maggior parte di noi si, anche se dovremmo ragionarci su per capire il perché. Non possiamo dunque delegare alla tecnica o ad un’astratta intelligenza artificiale la questione della scelta etica: emozioni, sentimenti e stati d’animo influenzano continuamente le nostre decisioni, e anche se difficilmente arriveremo ad avere risposte definitive e ai nostri interrogativi morali, non possiamo smettere di riflettere per chiarire a noi stessi che cosa pensiamo e perché.